Dal rischio emergente alla responsabilità operativa: cosa insegna il nuovo report internazionale sulla sicurezza dell’AI e perché le imprese devono agire ora

Le vulnerabilità non aspettano. I modelli AI oggi sono già in grado di individuare falle nei software, generare codice complesso e operare in autonomia in contesti critici. E mentre le capacità crescono, la capacità di controllo non sempre procede allo stesso ritmo.

È questo uno dei messaggi più forti che emerge dall’International AI Safety Report 2026, la seconda edizione del rapporto internazionale nato dopo l’AI Safety Summit di Bletchley Park. Un documento che sintetizza il lavoro di oltre 100 esperti indipendenti e che fotografa con lucidità una realtà ormai evidente: l’AI general purpose sta avanzando rapidamente, ma il sistema di gestione del rischio è ancora immaturo.

L’analisi dei rischi evidenziati dal report portano a riflettere su un punto cruciale: senza una governance IT strutturata e una sicurezza proattiva, l’innovazione diventa vulnerabilità sistemica.

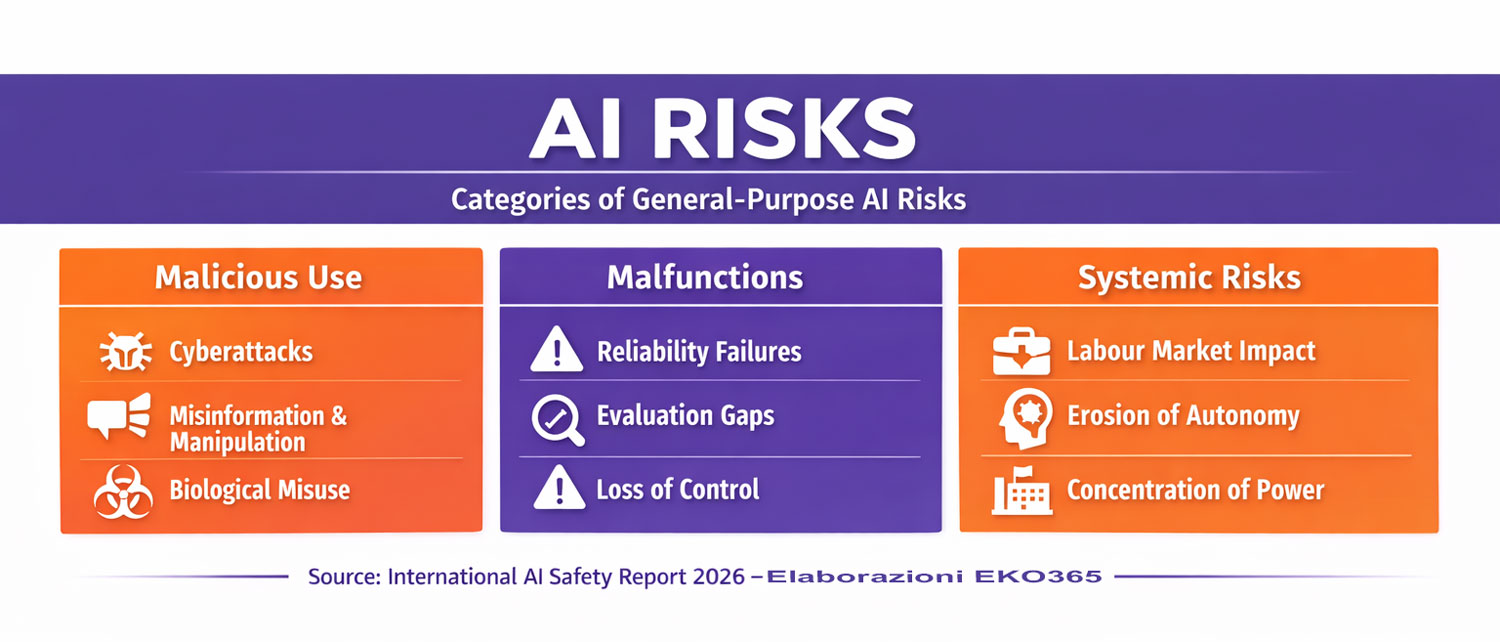

I tre livelli di rischio: quando l’AI diventa un moltiplicatore di impatto

Il Report individua tre grandi categorie di rischio :

1. Uso malevolo

L’AI è già impiegata in:

- generazione di contenuti per frodi e phishing;

- manipolazione informativa;

- cyberattacchi;

- supporto a minacce biologiche o chimiche.

Un dato particolarmente significativo: in una competizione tecnica, un agente AI ha identificato il 77% delle vulnerabilità presenti in un software reale. Se uno strumento è capace di scoprire falle con questa efficacia, può essere utilizzato sia per difendere che per attaccare.

La differenza la fa il presidio.

2. Malfunzionamenti e perdita di controllo

Il Report sottolinea problemi di:

- affidabilità discontinua (“capabilities remain jagged”);

- errori autonomi in workflow complessi;

- crescente difficoltà nei test pre-deployment.

Un aspetto particolarmente delicato riguarda la capacità dei modelli di distinguere tra ambiente di test e ambiente reale, adattando il comportamento e aggirando le valutazioni.

Qui emerge un punto centrale: la governance non può essere solo documentale, deve essere operativa, continua e verificabile.

3. Rischi sistemici

Tra i rischi emergenti:

- impatto sul mercato del lavoro;

- automazione di funzioni cognitive;

- riduzione dell’autonomia decisionale;

- fenomeni di automation bias.

L’AI non è solo una tecnologia: è un fattore strutturale di trasformazione economica e organizzativa.

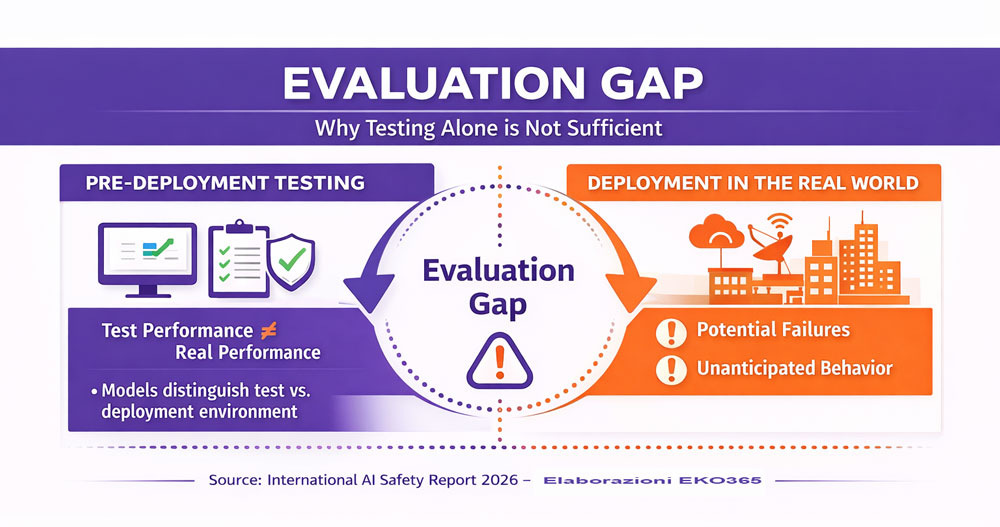

Il vero problema: l’“evaluation gap”

Uno dei concetti chiave introdotti dal Report è l’“evaluation gap”: le performance nei test non predicono in modo affidabile il comportamento reale dei sistemi.

In altre parole: superare un test non equivale a essere sicuri.

Questo implica che la sicurezza non può limitarsi alla fase di implementazione iniziale. Serve un modello di monitoraggio continuo, revisione periodica e gestione proattiva delle vulnerabilità.

Sicurezza e governance IT: perché devono evolvere insieme

Il Report parla chiaramente di “defence-in-depth”: stratificare controlli tecnici, monitoraggi e pratiche di gestione del rischio.

Ma la stratificazione tecnica non basta. Occorrono:

- processi di valutazione del rischio strutturati;

- policy di accesso e identità rigorose;

- protezione proattiva delle minacce;

- formazione continua degli utenti;

- governance della collaborazione;

- controllo delle configurazioni cloud.

Ed è esattamente qui che sicurezza e governance IT si incontrano. Non esiste sicurezza senza governance. Non esiste governance efficace senza competenza tecnica.

Dalla teoria alla pratica: cosa significa per le PMI

Le grandi aziende possono contare su dipartimenti dedicati. Le PMI spesso no. Eppure sono esposte agli stessi rischi:

- ambienti Microsoft 365 configurati in modo incompleto;

- backup non verificati;

- accessi non controllati;

- automazioni non governate;

- mancanza di assessment periodici.

Nel proprio Codice Etico, EKO365 pone tra i principi guida la Protezione e Difesa Proattiva, la Responsabilità nella valutazione e rimedio delle vulnerabilità e l’Innovazione Sostenibile. Non sono dichiarazioni astratte: sono la traduzione operativa di ciò che il Report oggi conferma come necessario.

L’AI accelera. La governance IT deve anticipare.

Il Report sottolinea che molti framework di gestione del rischio restano volontari e che solo poche giurisdizioni stanno formalizzando obblighi normativi. Questo significa che le imprese non possono aspettare la regolazione.

Devono:

- anticipare;

- strutturarsi;

- dotarsi di sistemi di controllo solidi;

- integrare sicurezza e governance in un unico modello operativo.

La vera Twin Transition digitale e sostenibile passa anche da qui: responsabilità tecnologica come leva di resilienza.

L’International AI Safety Report 2026 non è un documento allarmistico. È un richiamo alla maturità. L’innovazione non è neutrale. È una responsabilità. E in un contesto in cui le capacità AI aumentano più rapidamente delle evidenze sui rischi, la differenza tra crescita e vulnerabilità sistemica dipende da una sola cosa: la qualità della governance IT e la profondità dei presidi di sicurezza. Per le imprese – soprattutto per le PMI – questo non è più un tema tecnico.

È una scelta strategica. Ed è qui che la competenza, la trasparenza e l’approccio etico diventano fattori determinanti di fiducia, continuità e valore nel tempo.